在 ServBay 中使用 Ollama

ServBay 將強大的本地 AI 能力整合進您的開發環境,讓您能夠透過 Ollama 在 macOS 上輕鬆運行各種開源大語言模型 (LLM)。本文件將引導您在 ServBay 中啟用、設定、管理 Ollama 及其模型,並開始使用。

概述

Ollama 是一款廣受歡迎的工具,它簡化了於本地電腦下載、設定與運行大語言模型的流程。ServBay 嵌入 Ollama 作為獨立套件,並提供圖形化管理介面,開發者可輕鬆:

- 一鍵啟動、停止、重啟 Ollama 服務。

- 透過介面設定 Ollama 的各項參數。

- 瀏覽、下載與管理支援的 LLM 模型。

- 本地開發、測試或實驗 AI 應用,無需倚賴雲端服務。

前提條件

- 已於您的 macOS 系統安裝並執行 ServBay。

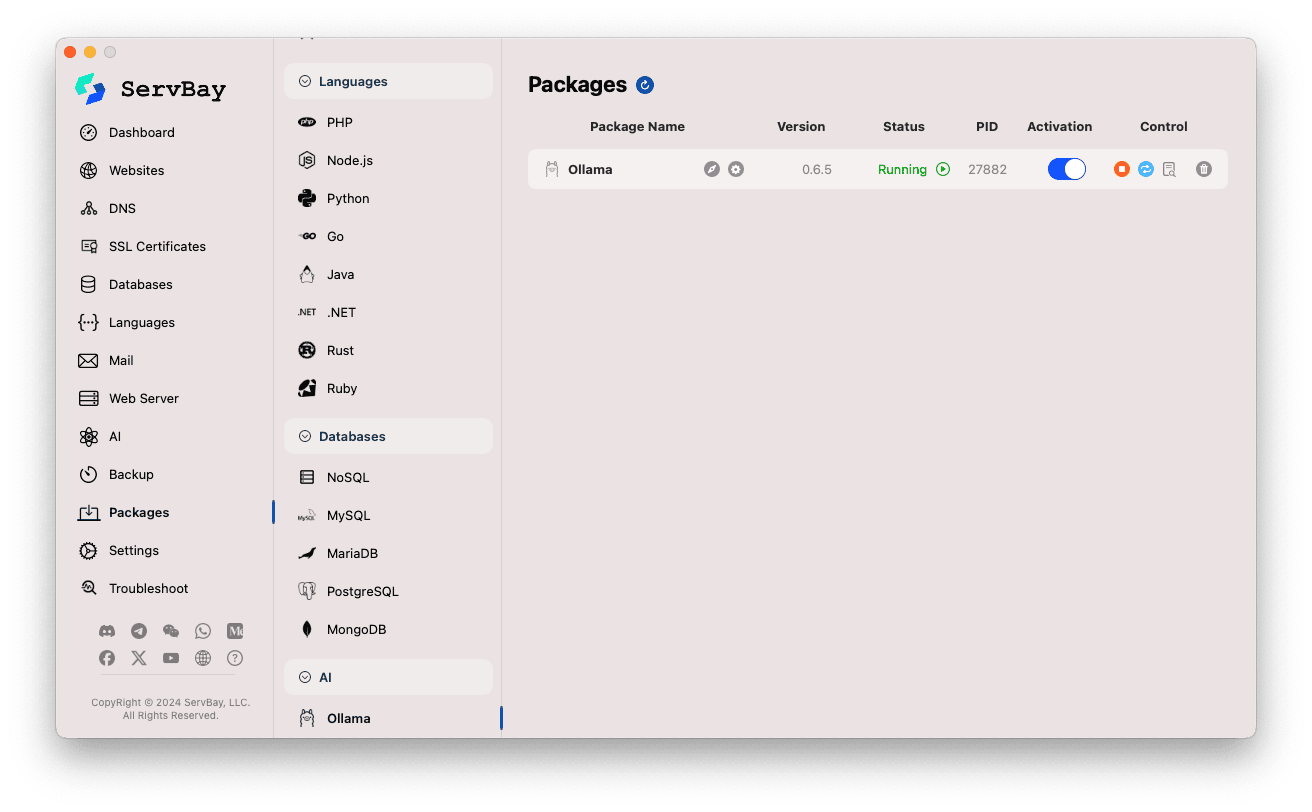

啟用與管理 Ollama 服務

您可透過 ServBay 主介面輕鬆管理 Ollama 套件。

進入 Ollama 套件:

- 開啟 ServBay 應用程式。

- 在左側導覽列點選

套件(Packages)。 - 於展開的列表中找到並點擊

AI分類。 - 點選

Ollama。

管理 Ollama 服務:

- 右側區塊會顯示 Ollama 套件的狀態資訊,包括版本號 (如

0.6.5)、執行情況 (Running或Stopped)、程序 ID (PID)。 - 使用右側控制按鈕:

- 啟動/停止: 橘色圓形按鈕用於啟動或停止 Ollama 服務。

- 重啟: 藍色刷新按鈕用於重啟 Ollama 服務。

- 設定: 黃色齒輪按鈕可前往 Ollama 設定頁面。

- 移除: 紅色垃圾桶按鈕用於解除安裝 Ollama 套件(請謹慎操作)。

- 更多資訊: 灰色資訊按鈕可能顯示其他訊息或存取日誌。

- 右側區塊會顯示 Ollama 套件的狀態資訊,包括版本號 (如

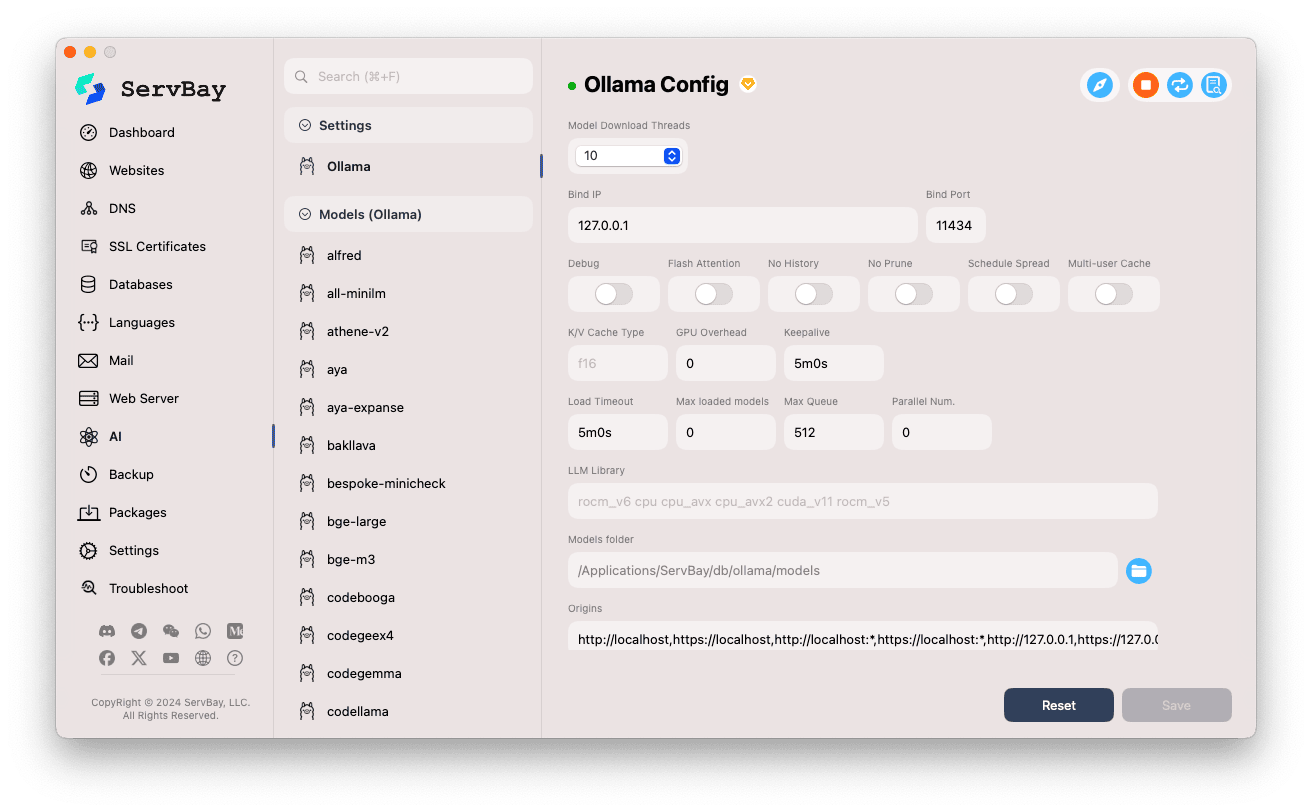

設定 Ollama

ServBay 提供圖形化介面,協助您依需求調整 Ollama 的運行參數。

進入設定介面:

- 開啟 ServBay 應用程式。

- 在左側導覽列點選

AI。 - 於展開列表找到並點擊

設定(Settings)分類。 - 點選

Ollama。

調整設定項目:

- Model Download Threads: 設定同時下載模型的執行緒數,以提升下載效率。

- Bind IP: Ollama 服務監聽的 IP。預設為

127.0.0.1,僅限本機存取。 - Bind Port: 服務監聽端口。預設為

11434。 - 布林開關選項:

Debug: 啟用除錯模式。Flash Attention: 可啟動 Flash Attention 優化(需硬體支援)。No History: 禁止記錄會話歷史。No Prune: 禁止自動清除未使用模型。Schedule Spread: 調度策略相關。Multi-user Cache: 多用戶快取相關。

- K/V Cache Type: Key/Value 快取類型,影響效能與記憶體佔用。

- GPU 相關:

GPU Overhead: GPU 資源分配相關設定。Keepalive: GPU 保持活動時間。

- 模型載入與隊列:

Load Timeout: 模型載入逾時時間。Max loaded models: 同時載入記憶體的最大模型數。Max Queue: 最多請求佇列長度。Parallel Num.: 並行處理請求數。

- LLM Library: 指定使用的底層 LLM 函式庫路徑。

- Models folder: Ollama 下載及存放模型的本地資料夾。預設為

/Applications/ServBay/db/ollama/models。可按資料夾圖示於 Finder 開啟此目錄。 - origins: 設定允許存取 Ollama API 的來源(CORS 跨域設定)。預設已包含常用本地位址(如

http://localhost,https://localhost,http://127.0.0.1,https://127.0.0.1等)。如需從其他網域的 Web 應用存取,請額外新增來源位址。

儲存設定: 修改後,請點擊右下角

Save按鈕使更動生效。

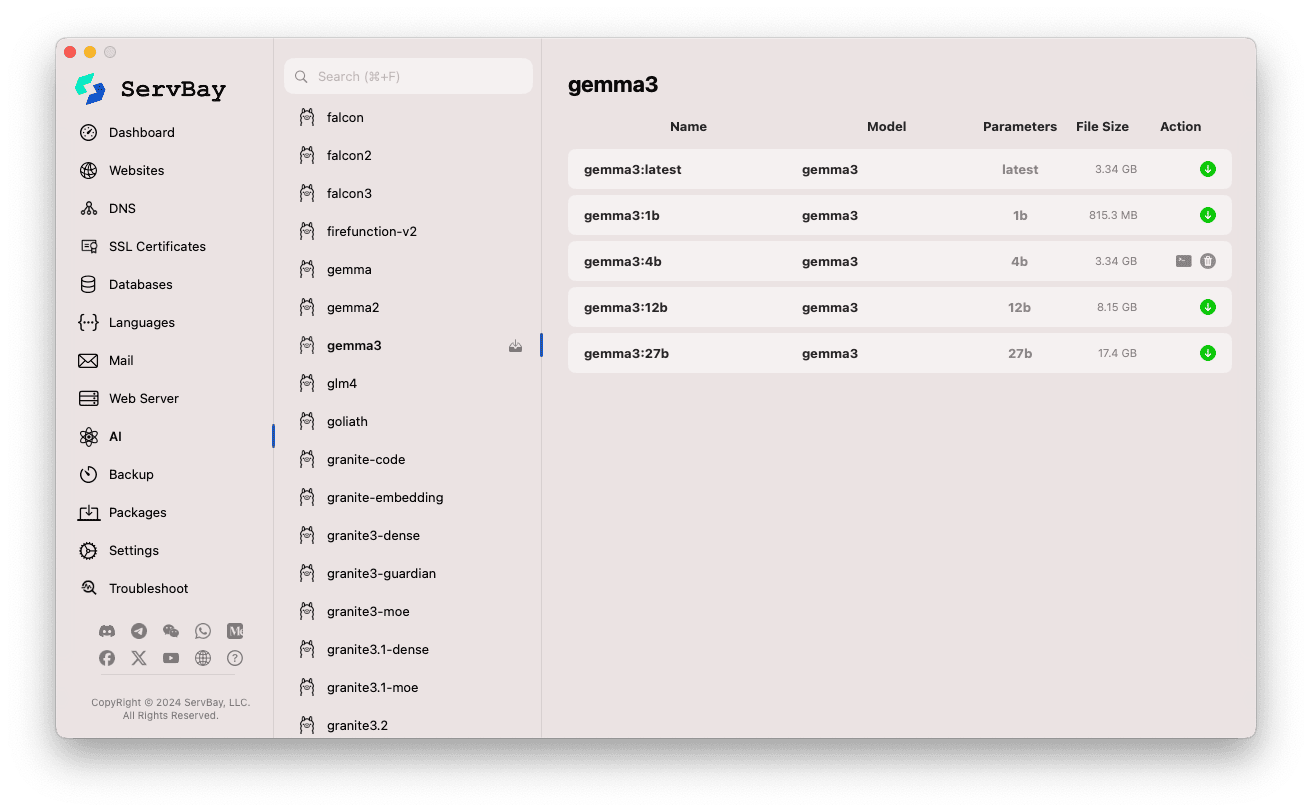

管理 Ollama 模型

ServBay 讓 Ollama 模型的探索、下載與管理變得簡便直觀。

進入模型管理介面:

- 開啟 ServBay 應用程式。

- 在左側導覽列點選

AI。 - 於展開列表找到並點選

Models (Ollama)。

瀏覽與下載模型:

- 左側顯示多個 Ollama 支援的模型庫(如

deepseek-r1,deepseek-v3,qwen3,gemma,llama3,mistral等)。點選其中任一模型庫名稱(如gemma3)。 - 右側會顯示該模型庫下不同變體或版本,通常依參數量區分(如

latest,1b,4b,12b,27b)。 - 每列說明模型名稱、基礎模型、參數量、檔案大小。

- 點右側綠色下載箭頭按鈕即可開始下載模型。下載進度會即時顯示。您可於

設定中調整下載執行緒數加速下載。 - 已下載的模型,下載按鈕將變灰或變為不可操作狀態。

- 左側顯示多個 Ollama 支援的模型庫(如

管理已下載模型:

- 已下載模型通常於列表中有明顯標示(如下載按鈕變灰、出現刪除按鈕)。

- 你可點選對應的刪除按鈕(垃圾桶圖示)來移除本地模型檔,釋放磁碟空間。

使用 Ollama API

Ollama 啟動後,會在設定的 Bind IP 與 Bind Port(預設為 127.0.0.1:11434)對外提供 REST API。你可用任何 HTTP 客戶端(如 curl、Postman 或程式語言函式庫)與已下載模型互動。

TIP

ServBay 貼心預設提供支援 SSL/TLS 加密、可 HTTPS 訪問的域名 https://ollama.servbay.host

您可直接以 https://ollama.servbay.host 領域名(而非 IP:Port)存取 Ollama 的 API。

範例:使用 curl 與已下載的 gemma3:latest 模型互動

請先確認已於 ServBay 下載並啟動 gemma3:latest 模型及 Ollama 服務。

bash

# 使用 ServBay 提供的 https

curl https://ollama.servbay.host/api/generate -d '{

"model": "gemma3:latest",

"prompt": "Why is the sky blue?",

"stream": false

}'

# 或採用傳統 IP:Port 方式

#curl http://127.0.0.1:11434/api/generate -d '{

# "model": "gemma3:latest",

# "prompt": "Why is the sky blue?",

# "stream": false

#}'1

2

3

4

5

6

7

8

9

10

11

12

13

2

3

4

5

6

7

8

9

10

11

12

13

命令說明:

http://127.0.0.1:11434/api/generate: Ollama 產生文本的 API 端點。-d '{...}': 發送 POST 請求體,包含 JSON 內容。"model": "gemma3:latest": 指定使用之模型名稱(需已下載)。"prompt": "Why is the sky blue?": 提出給模型的問題或提示。"stream": false: 設為false代表等候模型產出完整結果再一次回傳。若設為true,API 將以串流方式回應。

預期輸出:

您將在終端機看到一個 JSON 回應,response 欄位包含模型對 "Why is the sky blue?" 的答案。

json

{

"model": "gemma3:latest",

"created_at": "2024-...",

"response": "The sky appears blue because of a phenomenon called Rayleigh scattering...",

"done": true,

// ... 其他中繼資料

}1

2

3

4

5

6

7

2

3

4

5

6

7

CORS 注意: 若你要於瀏覽器 JavaScript 代碼存取 Ollama API,請確認您的 Web 應用來源(如 http://myapp.servbay.demo)已加進 Ollama 設定的 origins 名單,否則瀏覽器將因 CORS 政策阻擋請求。

應用場景

於 ServBay 本地運行 Ollama,有以下多重好處:

- 本地 AI 開發: 無需外部 API 或雲端服務,直接在本地開發及測試 LLM 應用。

- 快速原型設計: 快速嘗試各種開源模型,驗證創意方案。

- 離線使用: 即使無網路連接,亦可與 LLM 互動。

- 資料隱私: 所有資料與互動僅留於本機,毋須擔憂資料外洩。

- 成本效益: 省去依流量計費的雲端 AI 服務開銷。

注意事項

- 磁碟空間: 大語言模型通常體積龐大(數 GB 至數十 GB 不等),請確保硬碟有足夠剩餘空間。模型預設存於

/Applications/ServBay/db/ollama/models。 - 系統資源: 執行 LLM 極需 CPU、記憶體資源,若您的 Mac 具備相容 GPU,Ollama 亦可利用 GPU 加速(亦會佔用 GPU 資源)。請確保 Mac 配置符合所需模型運算需求。

- 下載時間: 模型下載視網速及體積可能需時較久。

- 防火牆: 若將

Bind IP改為0.0.0.0以利區域網內裝置連線,請確認 macOS 防火牆允許對 Ollama 所用端口 (11434) 的連入連線。

總結

ServBay 整合 Ollama,極大簡化於 macOS 上部署及管理本地大語言模型的流程。結合直覺圖形介面,開發者可輕鬆啟動服務、調整參數、下載模型,快速開展本地 AI 應用開發與測試,進一步強化 ServBay 作為一站式在地開發環境的價值。