ServBay'de Ollama Kullanımı

ServBay, güçlü yerel AI yeteneklerini geliştirme ortamınıza entegre ederek, macOS üzerinde Ollama aracılığıyla çeşitli açık kaynaklı büyük dil modellerini (LLM) zahmetsizce çalıştırmanıza olanak tanır. Bu doküman, ServBay'de Ollama ve modellerini nasıl etkinleştireceğinizi, yapılandıracağınızı, yöneteceğinizi ve kullanmaya başlayacağınızı adım adım açıklar.

Genel Bakış

Ollama, yerel bilgisayarınızda büyük dil modellerini indirme, kurma ve çalıştırmayı kolaylaştıran popüler bir araçtır. ServBay, Ollama'yı bağımsız bir paket olarak entegre etmiş ve kullanıcı dostu bir arayüz sunmuştur. Böylece geliştiriciler:

- Ollama servislerini tek tıkla başlatabilir, durdurabilir veya yeniden başlatabilir.

- Ollama'nın çeşitli parametrelerini arayüz üzerinden kolayca yapılandırabilir.

- Desteklenen LLM modellerini inceleyebilir, indirebilir ve yönetebilir.

- Yerelde AI uygulama geliştirme, test etme ve denemeler yapabilir; bulut servislerine bağımlı kalmazlar.

Ön Koşullar

- macOS sisteminize ServBay'in yüklenmiş ve çalışır durumda olması gereklidir.

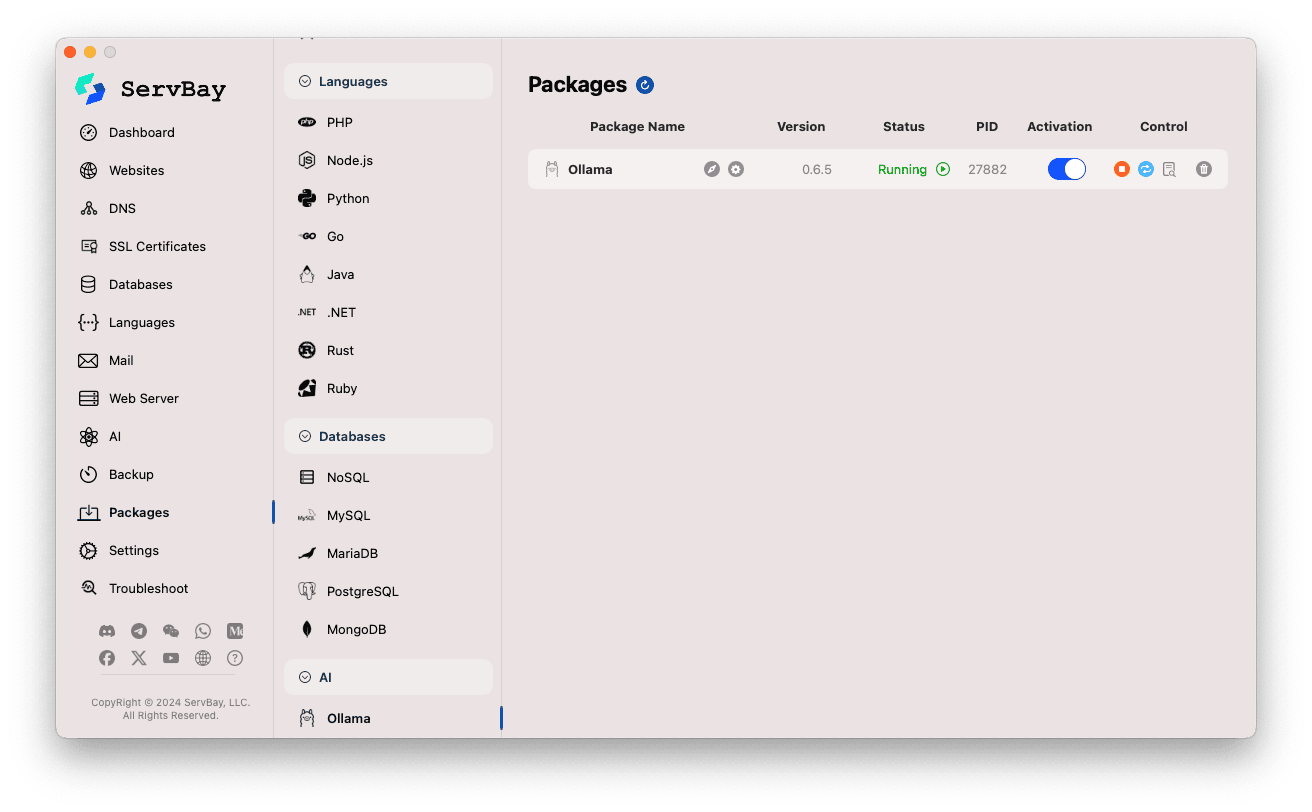

Ollama Servisini Etkinleştirme ve Yönetme

Ollama paketini ServBay’in ana arayüzü üzerinden kolaylıkla yönetebilirsiniz.

Ollama Paketi'ne Erişim:

- ServBay uygulamasını açın.

- Sol taraftaki menüden

Paketleri (Packages) seçin. - Açılan listede

AIkategorisini bulun ve tıklayın. - Ardından

Ollamayı seçin.

Ollama Servisinin Yönetimi:

- Sağ alanda Ollama paketiyle ilgili durum bilgilerini göreceksiniz: sürüm (ör.

0.6.5), çalışma durumu (ÇalışıyorveyaDurduruldu), süreç ID’si (PID) vb. - Sağdaki kontrol butonlarını kullanabilirsiniz:

- Başlat/Durdur: Turuncu yuvarlak buton Ollama servisini başlatır veya durdurur.

- Yeniden Başlat: Mavi ok buton servis için yeniden başlatma işlemi yapar.

- Yapılandırma: Sarı dişli butonu Ollama yapılandırma sayfasına yönlendirir.

- Sil: Kırmızı çöp kutusu butonu Ollama paketini kaldırır (dikkatle kullanınız).

- Daha Fazla Bilgi: Gri bilgi butonu ek bilgi veya loglara erişim sunabilir.

- Sağ alanda Ollama paketiyle ilgili durum bilgilerini göreceksiniz: sürüm (ör.

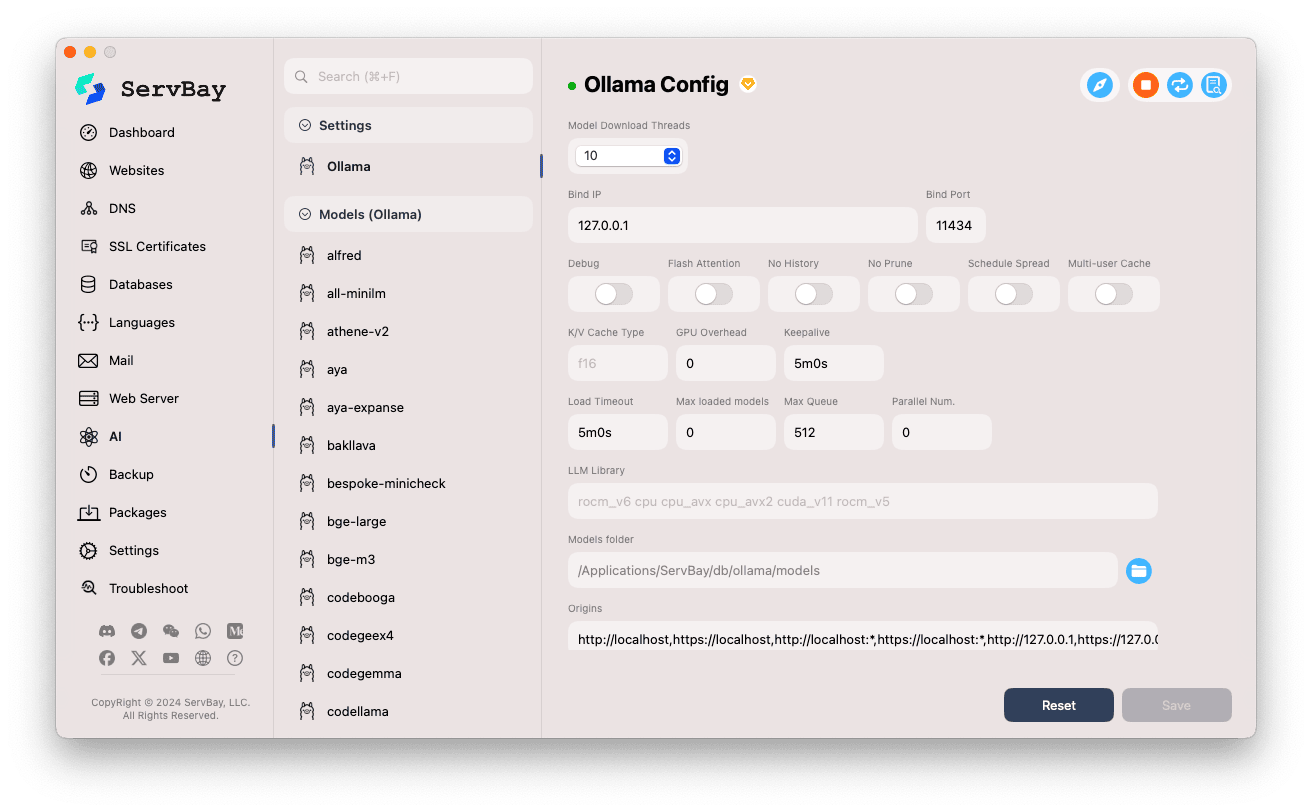

Ollama'yı Yapılandırma

ServBay, Ollama’nın çalışma parametrelerini görsel arayüzüyle farklı ihtiyaçlarınız için özelleştirmenizi sağlar.

Yapılandırma Arayüzüne Erişim:

- ServBay uygulamasını açın.

- Sol menüden

AIsekmesine gelin. - Açılan listeden

Ayarlar (Settings)kategorisini seçin. - Ardından

Ollamayı seçin.

Yapılandırma Seçeneklerini Ayarlama:

- Model İndirme Thread’leri: Birden fazla modeli aynı anda indirmek için thread sayısını belirleyin, böylece indirme hızını artırabilirsiniz.

- Bağlantı IP'si (Bind IP): Ollama'nın dinleyeceği IP adresi. Varsayılan değer

127.0.0.1'dir (sadece yerel erişime açıktır). - Bağlantı Portu (Bind Port): Ollama'nın dinleyeceği port. Varsayılanı

11434'tür. - Boolean Opsiyonlar:

Debug: Hata ayıklama modunu etkinleştirir.Flash Attention: Donanım destekliyorsa Flash Attention optimizasyonunu aktive eder.No History: Oturum geçmişi kaydını devre dışı bırakır.No Prune: Kullanılmayan modellerin otomatik temizlenmesini önler.Schedule Spread: Zamanlama stratejisiyle ilgili ayar.Multi-user Cache: Çoklu kullanıcı önbellekleme özellikleriyle ilgili.

- K/V Önbellek Türü: Anahtar/değer önbellek türü; performans ve bellek kullanımı üzerinde etkili olabilir.

- GPU ile İlgili Seçenekler:

GPU Overhead: GPU yönetim ayarları.Keepalive: GPU’nun aktif kalma süresini belirler.

- Model Yükleme ve Kuyruk:

Load Timeout: Modeli yükleme için maksimum bekleme süresi.Max loaded models: Aynı anda bellekte tutulacak maksimum model sayısı.Max Queue: Maksimum istek kuyruğu uzunluğu.Parallel Num.: Paralel işlenebilecek istek sayısı.

- LLM Library: Kullanılacak temel LLM kitaplık yolu.

- Models klasörü: Ollama'nın indirdiği ve sakladığı modellerin yerel klasörü. Varsayılan olarak

/Applications/ServBay/db/ollama/modelsdizinidir. Klasör simgesine tıklayarak Finder'da açabilirsiniz. - origins: Ollama API'sine hangi kaynaklardan erişileceğini (CORS ayarları) belirler. Varsayılan olarak yaygın yerel adresler (

http://localhost,https://localhost,http://127.0.0.1,https://127.0.0.1gibi) bulunur. Web uygulamanız farklı bir domain üzerinden erişecekse buraya ilgili adresi eklemeniz gerekir.

Yapıyı Kaydetme: Değişiklik yaptıktan sonra, sağ alt köşedeki

Kaydetbutonuna tıklayarak yapılandırmaları uygulayabilirsiniz.

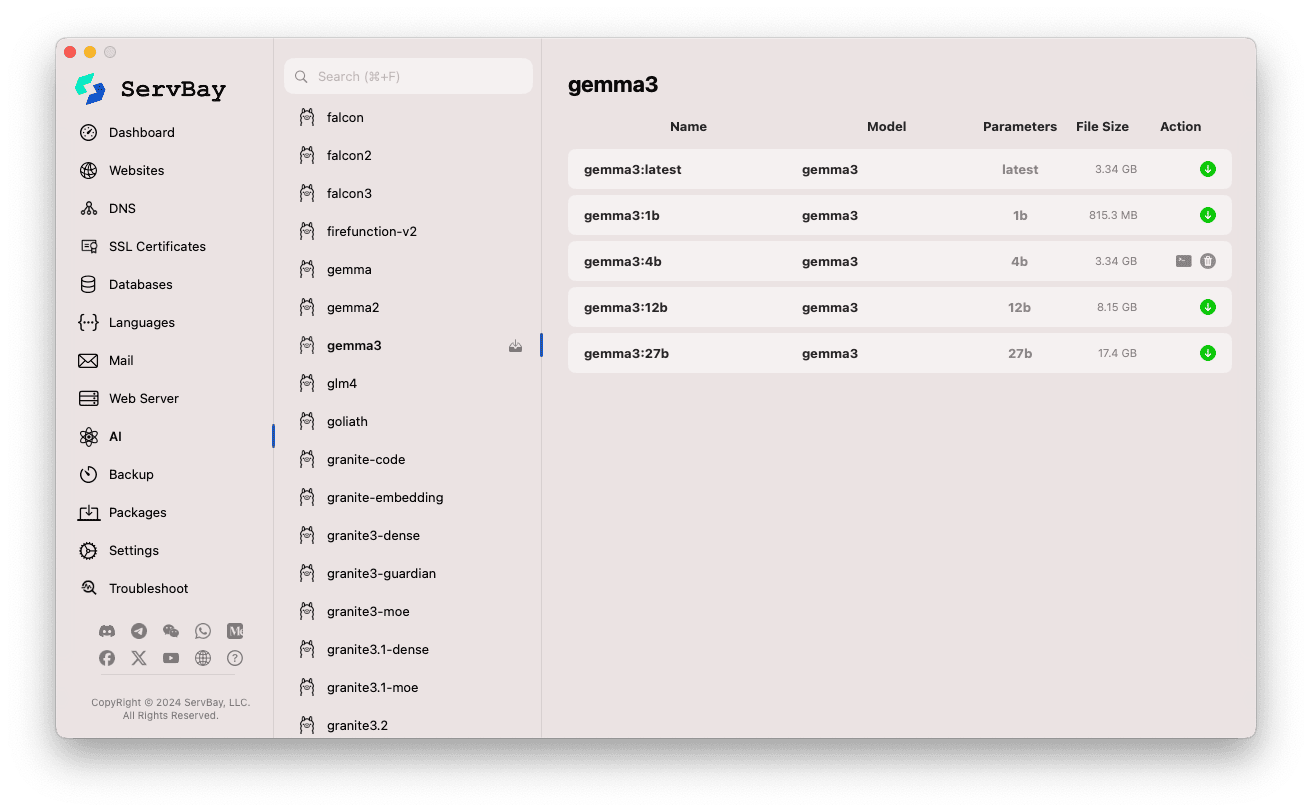

Ollama Modellerini Yönetme

ServBay ile Ollama modellerinin bulunması, indirilmesi ve yönetimi oldukça kolaylaştırılmıştır.

Model Yönetim Arayüzüne Erişim:

- ServBay uygulamasını açın.

- Sol menüden

AIsekmesini tıklayın. - Açılan menüden

Modeller (Ollama)seçeneğine gelin.

Modellere Göz Atma ve İndirme:

- Sol tarafta Ollama’nın desteklediği birçok model havuzu (ör.

deepseek-r1,deepseek-v3,qwen3,gemma,llama3,mistralvb.) listelenir. Bir havuzun adına (örneğingemma3) tıklayın. - Sağda, seçtiğiniz model havuzuna ait farklı varyantlar/güncellemeler (tipik olarak parametre sayılarına göre:

latest,1b,4b,12b,27bgibi) listelenir. - Her satırda modelin adı, temel modeli, parametre sayısı ve dosya boyutu gösterilir.

- En sağdaki yeşil indirme oku butonuna tıklayarak istenen modeli indirebilirsiniz. İlerleme arayüzde görüntülenecektir. İndirme hızınız yavaşsa

Ayarlarbölümünden thread sayısını arttırabilirsiniz. - İnen modellerde indirme butonu griye dönecek veya devre dışı görünecektir.

- Sol tarafta Ollama’nın desteklediği birçok model havuzu (ör.

İndirilen Modelleri Yönetme:

- İndirilen modeller kolayca ayırt edilebilir (ör. indirme butonu gri, silme butonu görünüyor).

- Çöp kutusu simgesine tıklayarak yerel model dosyasını silebilir ve depolama alanı boşaltabilirsiniz.

Ollama API Kullanımı

Ollama başlatıldığında, yapılandırmadaki Bind IP ve Bind Port değerlerinde (varsayılan olarak 127.0.0.1:11434) bir REST API hizmeti sunar. İstediğiniz herhangi bir HTTP istemcisi (ör. curl, Postman, programlama kütüphaneleri) ile indirdiğiniz modeller üzerinden etkileşimde bulunabilirsiniz.

TIP

ServBay, SSL/TLS şifreleme kullanan ve HTTPS erişimine olanak sağlayan https://ollama.servbay.host alan adını sunar.

Kullanıcılar Ollama API'sine doğrudan bir IP:port yerine, güvenli https://ollama.servbay.host adresiyle erişebilirler.

Örnek: curl ile indirilen gemma3:latest modeliyle etkileşim

Öncelikle, gemma3:latest modelini ServBay üzerinden indirdiğinizden ve Ollama servisinin çalışıyor olduğundan emin olun.

bash

# ServBay'in sunduğu https bağlantısı

curl https://ollama.servbay.host/api/generate -d '{

"model": "gemma3:latest",

"prompt": "Why is the sky blue?",

"stream": false

}'

# Veya klasik IP:port kullanımı

#curl http://127.0.0.1:11434/api/generate -d '{

# "model": "gemma3:latest",

# "prompt": "Why is the sky blue?",

# "stream": false

#}'1

2

3

4

5

6

7

8

9

10

11

12

13

2

3

4

5

6

7

8

9

10

11

12

13

Komut Açıklaması:

http://127.0.0.1:11434/api/generate: Ollama'nın metin oluşturma API uç noktasıdır.-d '{...}': JSON veri içeren bir POST isteği gönderir."model": "gemma3:latest": Kullanılacak modelin adını belirtir (mutlaka inmiş olmalı)."prompt": "Why is the sky blue?": Modele sormak veya vermek istediğiniz metin/prompt."stream": false: Eğerfalseise tam yanıt bir kerede döner;trueyapılırsa cevapları parça parça (stream şeklinde) alırsınız.

Beklenen Çıktı:

Terminalde, modelin "Why is the sky blue?" sorusuna verdiği cevabı içeren, response alanı bulunan bir JSON yanıtı görürsünüz.

json

{

"model": "gemma3:latest",

"created_at": "2024-...",

"response": "The sky appears blue because of a phenomenon called Rayleigh scattering...",

"done": true,

// ... diğer meta veriler

}1

2

3

4

5

6

7

2

3

4

5

6

7

CORS Uyarısı: Ollama API'ye tarayıcı içinden JavaScript ile erişecekseniz, web uygulamanızın kaynak adresinin (ör. http://myapp.servbay.demo) Ollama yapılandırmasındaki origins listesine ekli olduğundan emin olun. Aksi halde, CORS politikası nedeniyle tarayıcı erişimi engeller.

Uygulama Senaryoları

ServBay'de Ollama'yı yerelde çalıştırmak çok sayıda avantaj sunar:

- Yerel AI Geliştirme: Harici API veya bulut servisleri olmadan, tamamen yerelde LLM tabanlı uygulamalar geliştirin ve test edin.

- Hızlı Prototipleme: Farklı açık kaynak modellerini kolayca deneyin ve fikirlerinizi doğrulayın.

- Çevrimdışı Kullanım: Ağ bağlantısı olmasa bile LLM ile etkileşim mümkündür.

- Veri Gizliliği: Tüm veri ve etkileşimler bilgisayarınızda kalır; üçüncü kişilere aktarılmaz.

- Maliyet Etkinliği: Kullanıma göre faturalandırılan bulut AI servislerine ödeme yapmanız gerekmez.

Dikkat Edilecekler

- Disk Alanı: Büyük dil modeli dosyaları genelde çok büyüktür (birkaç GB’dan onlarca GB’a kadar), yeterli boş alana sahip olduğunuzdan emin olun. Modeller standart olarak

/Applications/ServBay/db/ollama/modelsdizinine indirilir. - Sistem Kaynakları: LLM’ler CPU ve RAM’i yoğun şekilde kullanır; Mac’inizde uyumlu bir GPU varsa, Ollama bu GPU’yu hızlandırmada kullanabilir. Model gerekliliklerine göre sisteminizin yeterli olduğundan emin olun.

- İndirme Süresi: Model boyutları ve internet hızınıza göre indirme işlemleri uzun sürebilir.

- Güvenlik Duvarı: Başka ağ cihazlarından erişim için

Bind IPayarını0.0.0.0yaparsanız, macOS güvenlik duvarınızın Ollama’nın kullandığı porta (11434) gelen trafiğe izin verdiğinden emin olun.

Özet

ServBay, Ollama entegrasyonu sayesinde macOS üzerinde yerel büyük dil modeli kurulum ve yönetimini büyük ölçüde basitleştirir. Sezgisel arayüzüyle servisleri başlatmak, yapılandırmaları değiştirmek, model indirmek ve yerel AI uygulama geliştirmeye hızlıca başlamak mümkün olur. Böylelikle, ServBay birinci sınıf, hepsi bir arada yerel geliştirme ortamı kimliğini daha da güçlendirir.